L’entretien est une étape incontournable de tout recrutement. Il peut poursuivre plusieurs objectifs : informer et attirer le candidat, évaluer sa motivation et ses compétences pour le poste, ou encore explorer l’adéquation entre ses valeurs et la culture de l’organisation. L’entretien structuré (structured interview) vise à évaluer les compétences des candidats ; à ce titre, il est souvent conduit par le hiring manager.

L’entretien structuré est parfois réduit – à tort – à l’usage d’une simple trame d’entretien, c’est-à-dire une liste de questions potentielles, organisée par rubriques (parcours, motivations, compétences, etc.). En réalité, l’entretien structuré est une méthode bien plus précise et rigoureuse.

Cet article en présente les principes et la mise en œuvre de manière détaillée et accessible. Il s’appuie sur la littérature scientifique [1, 2], notamment sur l’excellent ouvrage de Pettersen et Durivage [3], ainsi que sur notre propre expérience.

1. La structuration de l’entretien de recrutement

On peut distinguer quatre niveaux de structuration dans la conduite d’un entretien de recrutement :

- Niveau 1 – Structure absente : aucune trame, aucune question préparée.

- Niveau 2 – Structure faible : liste de thèmes à couvrir.

- Niveau 3 – Structure élevée : liste de questions prédéfinies. Le recruteur peut si besoin reformuler une question et poser des questions d’approfondissement.

- Niveau 4 – Structure maximale : liste de questions prédéfinies, identiques et posées dans le même ordre pour tous les candidats, et sans possibilité de questions d’approfondissement.

Les niveaux 1 et 2 correspondent aux entretiens non structurés – qui représentent la grande majorité des entretiens d’embauche – tandis que les niveaux 3 et 4 correspondent aux entretiens structurés.

La recherche montre sans ambiguïté que plus l’entretien est structuré, plus sa capacité à prédire la performance professionnelle augmente [4]. Cependant, les gains au-delà du niveau 3 sont peu significatifs [5] et le niveau 4 soulève des enjeux d’acceptabilité, tant du côté des candidats que des recruteurs.

La structuration est le bouclier contre les biais humains. Par exemple, l’appréciation d’un candidat sur une caractéristique précise (comme son apparence physique) tend à s’étendre à d’autres dimensions (professionnalisme, intelligence, etc.), un phénomène appelé effet de Halo. Les recherches montrent également que la première impression du recruteur, formée dans les toutes premières minutes, influence fortement la suite de l’entretien. Par le biais de confirmation, le recruteur aura alors tendance, consciemment ou non, à orienter ses questions de manière à conforter cette première impression.

2. Les deux avantages de l’entretien structuré

L’entretien structuré présente deux avantages majeurs par rapport à l’entretien traditionnel, non structuré.

2.1 La standardisation : évaluer tous les candidats de la même manière

Toute situation de sélection (recrutement, concours, etc.) implique une comparaison des postulants. Pour que celle-ci soit valide, le principe de standardisation doit avoir été observé : ces derniers doivent avoir été évalués dans les mêmes conditions. Que penseriez-vous d’une épreuve d’un concours dans laquelle les candidats répondent à des questions différentes ? C’est pourtant ce que font les entretiens de recrutement non structurés.

2.2 La pertinence : évaluer uniquement des critères liés au poste

Dans un entretien structuré, chaque question est prédéfinie et vise à évaluer un critère pertinent, c’est-à-dire une aptitude professionnelle liée au poste. La pertinence est une exigence légale en matière d’évaluation des candidats (article L. 1221-8 du Code du travail).

L’anecdote suivante, que m’a confiée l’un de mes anciens étudiants aujourd’hui psychologue du travail dans un Centre de Sélection et de Concours de la Gendarmerie Nationale, illustre cette notion de pertinence. Le processus de sélection des futurs gendarmes comprend un entretien devant un jury, au sein duquel siège notamment un gradé. L’un d’eux avait pour habitude de poser aux candidats des questions telles que : « Connaissez-vous la date de naissance de Napoléon ? »

Si répondre correctement à cette question peut susciter une impression favorable auprès du jury, on peut légitimement s’interroger sur ce qu’elle révèle réellement de la capacité du candidat à exercer les missions d’un gendarme.

3. Définir la scorecard

La scorecard est l’élément central de l’entretien structuré. C’est la grille d’évaluation des candidats pour un poste donné, lors de cet entretien. Elle indique :

- Quels critères (compétences) sont évalués

- Comment ils sont pondérés

- Les questions utilisées pour évaluer les critères

- Comment sont scorées les réponses à ces questions

Le tableau ci-dessous montre une scorecard pour un poste d’infirmier en soins généraux dans une unité neuro vasculaire au sein d’un CHRU.

On peut facilement créer une grille d’entretien à partir de la scorecard : le document sur lequel peut s’appuyer le recruteur qui fait passer un entretien structuré, et qui comporte : a) l’introduction ; b) les questions préparées et regroupées en suivant une séquence appropriée ; et c) la conclusion.

Voyons comment élaborer concrètement une scorecard.

3.1 Comment définir les critères évalués

L’identification des compétences et des qualités requises pour un poste relève de l’analyse du travail. Aux Etats-Unis, elles sont souvent catégorisées au travers de la typologie KSAO : Knowledge (connaissances), Skills (compétences), Aptitudes (aptitudes), et Others (autres caractéristiques).

Il existe plusieurs méthodes standardisées d’analyse de poste : la méthode des incidents critiques de Flanagan [6], la grille de Kelly [7] ou encore le PAQ (Position Analysis Questionnaire). Ces méthodes permettent de décrire les activités et les tâches qui caractérisent un poste, et d’identifier les compétences, les aptitudes ou encore les traits de personnalité nécessaires (les KSAO’s) pour les réaliser.

La méthode des incidents critiques est une technique systématique développée par John Flanagan pour identifier les comportements déterminants le succès ou l’échec dans un poste donné. Elle est particulièrement écologique car elle part de situations réelles observées sur le terrain.

Concrètement, il s’agit de réaliser des entretiens individuels ou collectifs avec des personnes familières du poste (typiquement, des managers) afin de collecter des récits d’incidents où la personne en poste a soit été particulièrement efficace (incident critique positif), soit particulièrement inefficace (incident critique négatif). Chaque incident doit répondre à trois questions :

- Quelle est la situation ?

- Quel a été le comportement réalisé ?

- Quel a été le résultat ou l’impact de ce comportement ?

Un exemple d’incident critique positif pour un poste de chargé de relation client est le suivant :

Un client très mécontent menace de résilier son contrat [= contexte]. Le chargé de relation reste calme, reformule les griefs du client, trouve une solution avec les équipes internes et rappelle le client dans les délais annoncés [= comportement réalisé]. Le client est satisfait et renouvelle son contrat [= résultat].

Le regroupement des incidents critiques permet d’identifier les comportements associés aux compétences clés du poste. Pour le poste de chargé de relation client, ces compétences seront entre autres la capacité de gestion des situations tendues, une communication orientée client, et un comportement orienté solution.

En pratique, on pourra objecter que l’analyse du travail est difficilement réalisable car trop coûteuse en temps ou complexe à mettre en œuvre. A défaut, l’identification des critères pertinents à évaluer peut s’appuyer sur la fiche de poste, à condition que celle-ci soit suffisamment détaillée, actualisée et validée par le manager concerné.

3.2 Comment définir les questions

Il est impératif de poser plusieurs questions pour chaque critère évalué, typiquement 2 ou 3. On distingue deux principaux types de questions.

Les questions comportementales invitent le candidat à décrire ce qu’il a fait dans une situation concrète. Par exemple : « Parlez-moi d’une fois où vous n’avez pas pu respecter une échéance. Qu’avez-vous fait ? »

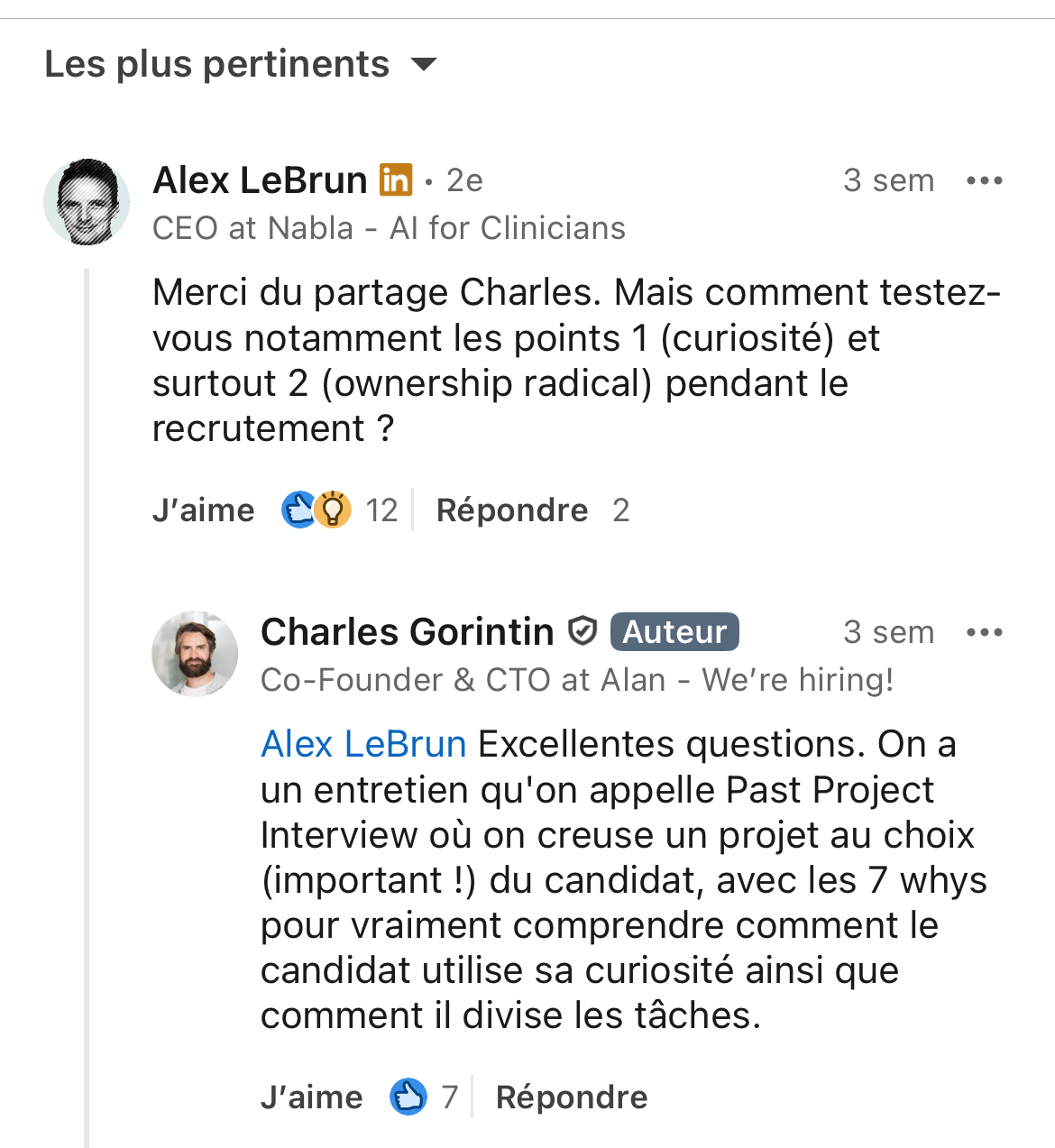

Ce type de questions est par exemple utilisé par Alan dans le Past Project Interview, un entretien qui consiste à revenir en détail sur un projet antérieur réalisé par le candidat, afin d’explorer ses comportements et ses modes de fonctionnement.

Les questions situationnelles placent le candidat dans un scénario hypothétique, et lui demandent ce qu’il ferait. Par exemple : « Un patient refuse un soin important. Quelle approche adoptez-vous pour le convaincre ? ». Si la méthode des incidents critiques a été utilisée, ces questions peuvent s’appuyer directement sur les situations recueillies.

Des questions de connaissances peuvent aussi être utilisées. Par exemple : « Comment fait-on pour construire un histogramme dans Excel ? »

Le type de questions à privilégier dépend de plusieurs considérations. Sur le plan scientifique, les questions comportementales prédisent généralement mieux la performance professionnelle que les questions situationnelles [8]. Sur le plan pratique, pour des profils ayant peu d’expérience professionnelle, les questions situationnelles et de connaissances sont souvent plus adaptées.

3.3 Comment définir le scoring des réponses

L’objectif est d’obtenir un score pour chaque critère. Une méthode possible consiste à évaluer directement un critère à partir de l’ensemble des réponses aux questions correspondantes, mais on recommande plutôt d’évaluer la réponse à chaque question liée au critère et d’agréger ensuite les scores.

Le scoring d’une réponse peut se faire suivant deux méthodes.

1) Evaluer la réponse suivant des éléments de réponse attendus en additionnant les points

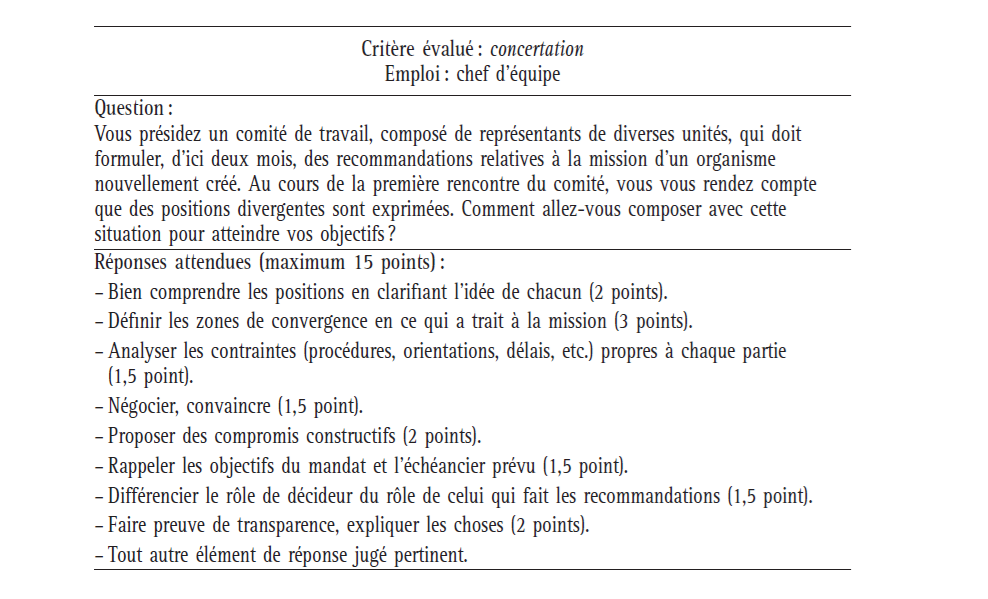

Le tableau ci-dessous donne un exemple de cette méthode :

Pour les questions comportementales, dans lesquelles le candidat doit rapporter une expérience professionnelle passée, les éléments de réponse attendus peuvent être ceux de la méthode STAR :

- S (Situation) : la situation professionnelle rapportée est-elle pertinente ?

- T (Tâche) : quel était l’objectif à atteindre ?

- A (Action) : les actions entreprises par le candidat sont-elles pertinentes au regard de la situation et de l’objectif ?

- R (Résultat) : dans quelle mesure les actions entreprises ont-elles été efficaces ?

Il n’est pas toujours évident de distinguer la Situation de la Tâche, car la seconde peut être considérée comme un élément de la première. Par ailleurs, le critère Tâche n’évalue pas directement la compétence ciblée par la question mais plutôt la capacité du candidat à décrire clairement ce qui était attendu de lui. Il est ainsi recommandé d’évaluer seulement les critères Situation, Action et Résultat [3].

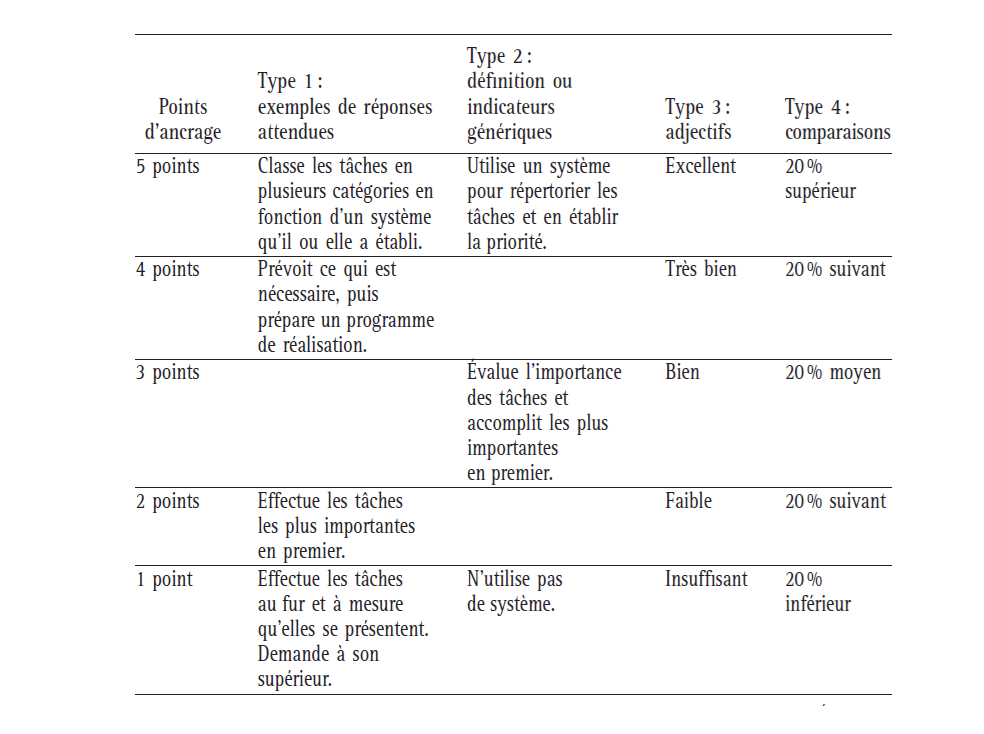

2) Evaluer globalement la réponse suivant une échelle à ancrages comportementaux (BARS)

Le tableau ci-dessous donne un exemple de BARS (Behaviorally Anchored Rating Scale) :

On peut utiliser différents labels pour étiqueter une même échelle. L’exemple ci-dessous montre différentes BARS pour scorer les réponses à la question « Pouvez-vous donner un exemple tiré de votre expérience où vous avez dû établir des priorités et planifier votre travail ? »

Aujourd’hui, l’IA – et en particulier les LLM – permet d’automatiser le scoring des réponses, ce qui allège considérablement le travail du recruteur (voir partie 5).

3.4 Comment réaliser l’évaluation des candidats

A l’issue d’un entretien, on évalue les candidats de la façon suivante :

- On score la réponse à chaque question

- On score chaque critère en additionnant les scores aux questions correspondantes

- On calcule un score global qui est la somme pondérée des scores aux critères

Les poids attribués aux critères doivent refléter leur importance relative dans la réussite professionnelle au poste. Une méthode pratique consiste à leur attribuer une valeur comprise entre 0 et 1, de telle sorte que la somme des poids soit égale à 1.

Le tableau suivant donne un exemple d’évaluation d’un candidat suivant la scorecard indiquée ci-dessus :

Le score global de ce candidat est : 7*0.30 + 9*0.20 + 8*0.15 + 7*0.20 + 8*0.15 = 7.7

On notera qu’il est possible – et même recommandé – de faire évaluer les réponses d’un candidat par plusieurs évaluateurs, humains et/ou une IA, de manière indépendante. Le score final peut alors être obtenu en calculant la moyenne des scores attribués. Cette approche s’appuie sur le principe de la sagesse des foules et permet de renforcer la fiabilité de l’évaluation. Par exemple, la combinaison d’évaluateurs humains et d’IA offre le plus haut niveau de précision dans des domaines comme le diagnostic médical.

4. Quelques règles pratiques

1) Les entretiens doivent être réalisés par le(s) même(s) personnes(s).

2) Etant donné la durée habituelle d’un entretien (généralement entre 45 et 90 minutes), il est raisonnable de limiter le nombre de critères à 3 à 7, évalués chacun au moyen de 2 ou 3 questions. Il est ainsi recommandé un total d’environ 10 à 20 questions.

3) Lors de l’entretien, le recruteur doit recueillir l’ensemble des informations nécessaires pour évaluer le candidat. Ainsi, lorsque celui-ci fournit une réponse trop générale, imprécise ou incomplète, le recruteur peut l’inviter à la préciser au moyen de questions d’approfondissement (niveau 3 de structuration).

Ces questions de relance s’appliquent aux questions situationnelles et comportementales. Dans le cas des questions comportementales, elles visent notamment à amener le candidat à compléter sa réponse selon les critères STAR, par exemple :

Situation

- Qu’est-il arrivé exactement ?

- Qui était le client ? S’agissait-il d’un nouveau client ? D’un client important ?

- Etait-ce la première fois que ce client formulait une plainte ?

- Qui était l’employé ? S’agissait-il d’un bon employé ou d’un employé problématique ?

Action

- Qu’avez-vous fait exactement ?

- Qu’avez-vous dit au client ?

- Qu’avez-vous dit à l’employé (ou aux employés) en cause ?

Résultat

- Quelles ont été les conséquences de ne pas avoir obtenu d’abord l’autorisation du service des achats ? Qu’est-il arrivé par la suite ?

- Quelles ont été les conséquences exactes d’avoir intégré les sous-traitants dans la préparation des offres de service ?

Les questions d’approfondissement doivent être utilisées en priorité pour les questions portant sur les critères les plus importants (c’est-à-dire les plus fortement pondérés), afin de sécuriser l’évaluation des compétences clés.

4) Il est conseillé de fournir à l’avance la liste des questions au candidat, par exemple 30 min ou une heure avant le début de l’entretien. La possibilité pour les candidats de préparer l’entretien réduit le risque de réponses imprécises et incomplètes.

5) Dès le début de l’entretien, informer le candidat que celui-ci se déroule dans un temps limité et qu’il lui revient de gérer ce temps pour répondre à l’ensemble des questions.

5. Le paradoxe de l’entretien structuré et comment l’IA peut le résoudre

L’entretien structuré illustre un paradoxe révélateur du décalage entre la recherche et la pratique en matière de recrutement [9]. Alors que les méta-analyses montrent qu’il s’agit de la méthode la plus prédictive de la performance professionnelle [10], il demeure pourtant relativement peu utilisé par les recruteurs. Les raisons en sont connues [11] :

- Un entretien très structuré ressemble davantage à un examen oral qu’à un véritable entretien, et frustre ainsi le besoin d’autonomie et de pouvoir des recruteurs. Nombre d’entre eux surestiment leur capacité à évaluer les candidats par l’intuition, et l’entretien structuré ne leur permet pas d’exercer cette capacité [12, 13].

- L’entretien structuré peut ne pas être aligné avec la culture et les normes de l’entreprise.

- Il nécessite du temps et des ressources financières pour être mis en œuvre.

- Les recruteurs n’ont pas forcément connaissance des résultats scientifiques sur la supériorité de cette méthode.

Face à ce constat, il est pertinent d’automatiser tout ou partie des entretiens structurés à l’aide de l’IA. Cela permet de conserver les principaux avantages de cette méthode – notamment sa capacité à prédire la réussite professionnelle – tout en réduisant ses principaux freins (coût, contraintes de mise en œuvre et acceptabilité parfois limitée).

Concrètement, il est désormais possible de concevoir et de déployer une solution dans laquelle un agent IA administre les questions aux candidats, tandis qu’un ou plusieurs LLM assistent le recruteur en générant une première version de la scorecard et en proposant un scoring des réponses, qui peut ensuite être validé et ajusté par des évaluateurs humains.

L’entretien vidéo différé (automated video interviews ou AVI) s’en rapproche, mais les solutions actuelles n’implémentent ni la gestion d’une scorecard, ni les questions d’approfondissement. Autrement dit, elles ne permettent aucune dynamique conversationnelle (niveau 4 de structuration), ce qui joue probablement en défaveur de l’engagement des candidats.

Aux Etats-Unis, les AVI sont largement utilisés dans les phases de pré-sélection. En France, Michel-Edouard Leclerc avait annoncé en 2020 vouloir expérimenter cette méthode en alternative au CV. Cet intérêt s’explique aisément, compte tenu des réductions de coûts et des gains d’efficacité permis par l’automatisation.

En parallèle, la recherche scientifique sur les AVI est à la fois encore émergente et déjà prolifique [14, 15]. A ce jour, les résultats montrent que la validité des AVI reste limitée, mais surtout qu’ils ne sont pas discriminants par rapport à des critères comme le genre ou l’origine ethnique [16]. Ce dernier résultat est particulièrement important au regard des exigences de l’AI Act pour les systèmes d’IA utilisés dans le recrutement.

Références

[1] Campion, M. A., Palmer, D. K., & Campion, J. E. (1997). A review of structure in the selection interview. Personnel Psychology, 50(3), 655–702.

[2] Levashina, J., Hartwell, C. J., Morgeson, F. P., & Campion, M. A. (2014). The structured employment interview: Narrative and quantitative review of the research literature. Personnel Psychology, 67(1), 241–293.

[3] Pettersen, N., & Durivage, A. (2006). L’entrevue structurée. Pour améliorer la sélection du personnel. Québec : Presses de l’Université du Québec.

[4] Wiesner, W. H., & Cronshaw, S. F. (1988). A meta-analytic investigation of the impact of interview format and degree of structure on the validity of the employment interview. Journal of Occupational Psychology, 61(4), 275–290.

[5] Huffcutt, A. I., & Arthur, W. (1994). Hunter and Hunter (1984) revisited: Interview validity for entry-level jobs. Journal of Applied Psychology, 79(2), 184–190.

[6] Flanagan, J. C. (1954). The critical incident technique. Psychological Bulletin, 51(4), 327–358.

[7] Kelly, G. A. (1955). The psychology of personal constructs. New York: Norton.

[8] Pulakos, E. D., & Schmitt, N. (1995). Experience-based and situational interview questions: Studies of validity. Personnel Psychology, 48(2), 289–308.

[9] Bruchon-Schweitzer, M. et Laberon, S. (2011). Chapitre 3. Pratiques D’évaluation des Recruteurs : Situation, Evolutions et Déterminants. In S. Laberon (Eds.), Psychologie et recrutement : Modèles, pratiques et normativités (pp. 75–105). De Boeck Supérieur.

[10] Sackett, P. R., Zhang, C., Berry, C. M., & Lievens, F. (2022). Revisiting meta-analytic estimates of validity in personnel selection: Addressing systematic overcorrection for restriction of range. Journal of Applied Psychology, 107(11), 2040–2068.

[11] van der Zee, K. I., Bakker, A. B., & Bakker, P. (2002). Why are structured interviews so rarely used in personnel selection?. The Journal of applied psychology, 87(1), 176–184.

[12] Highhouse, S. (2008). Stubborn reliance on intuition and subjectivity in employee selection. Industrial and Organizational Psychology: Perspectives on Science and Practice, 1(3), 333–342.

[13] Dana, J., Dawes, R., & Peterson, N. (2013). Belief in the unstructured interview: The persistence of an illusion. Judgment and Decision Making, 8(5), 512–520.

[14] Hickman, L., Bosch, N., Ng, V., Saef, R., Tay, L., & Woo, S. E. (2022). Automated video interview personality assessments: Reliability, validity, and generalizability investigations. The Journal of applied psychology, 107(8), 1323–1351.

[15] Liff, J., Mondragon, N., Gardner, C., Hartwell, C. J., & Bradshaw, A. (2024). Psychometric properties of automated video interview competency assessments. The Journal of applied psychology, 109(6), 921–948.

[16] Campion, M. A. (2025). Can Legal and Professional Personnel Selection Principles be Met With Machine Learning (Artificial Intelligence)? Human Resource Management, 0, 1–21.

.svg)

.svg)

.svg)

.svg)